Quoi de neuf dans la Silicon Valley ?

L’Intelligence Artificielle Générale (AGI) : La prochaine frontière après les agents et les modèles à raisonnement ?

Retour

Tout le monde le dit : 2025 sera l'année des agents d'IA. Cette catégorie, l'IA agentique, est une étape après les chatbots IA classiques. L’IA agentique peut accomplir des tâches de manière autonome avec peu de supervision humaine, elle comprend le langage naturel, prend des décisions et s’adapte aux changements. C'est un pas en avant vers l'autonomie (agency) des systèmes.

Au congrès du WEF à Davos en janvier 2025, l'IA agentique était omniprésente. Et il y a eu l'apparition soudaine de DeepSeek dans le paysage, la société chinoise d'IA et de ses modèles open source très peu couteux à l'usage, compétitifs par rapport aux meilleurs LLMs américains. Qui plus est, ils ont été développés pour une fraction des couts de développement aux USA mais avec des puces IA anciennes du fait de l'embargo américain contre la Chine sur les puces IA de dernière génération de Nvidia. Par aideurs, l'annonce par Donald Trump de la création d'une société de construction de datacenters géants pour l'IA, le projet Stargate, prévu pour investir en 100 et 400Md$ (uniquement des fonds privés américains, japonais et des émirats) en quatre ans a aussi fait parler d'elle.

Ce qui se passe c'est que le rythme des innovations dans l'IA s'accélère en même temps que les investissements gigantesques et inédits pour les technologies numériques se multiplient. Les cycles de développement des nouveaux produits se compressent et les nouveaux développements apparaissent tous les deux à trois mois. Par exemple, il y a eu en trois mois une série d'annonces de nouveaux produits IA toujours plus puissants : OpenAI a lancé Operator, un agent IA semi autonome et les modèles o1, o3 mini, Sora, ChatGPT Search, Elon Musk a annoncé un éditeur d'images pour son chatbot Grok, Alibaba a son LLM Qwen 2.5 Max, Google son Gemini 2.0 Flash et le projet Astra (agent) avec DeepMind et aussi Notebook LM Plus, Amazon avec son Nova, Meta avec son modèle Llama 3.3 70B et Deep Research, Microsoft avec l'AI Builder. DeepSeek a son model R1. Mistral a annoncé Mistral Small 3, les modèles Mistral Large 24.00 Codestral 25.01 (pour la génération de programmes).

Cette rapidité des changements dans l'IA pose bien entendu des problèmes à la réglementation qui est beaucoup plus lente.

Dans le paysage encombré de l'IA ont commencé à flotter des questions sur la prochaine étape : quand et pourra-t -on passer des modèles d'IAs à raisonnement, comme o1 and o3-mini d'OpenAI à l'étape ultime : l'intelligence générale artificielle (AGI).

On parle même de la Super Intelligence Artificielle (ASI). Ce serait un système dont les capacités intellectuelles surpassent celles des humains dans presque tous les domaines. Elle serait capable de résoudre des problèmes que les humains ne peuvent même pas envisager.

Mais c'est vraiment de l'AGI dont on parle le plus pour le moment.

A Davos, on a défini plus ou moins l'AGI comme un système qui vise à reproduire les capacités cognitives humaines d'apprentissage, d'adaptation et de généralisation des connaissances à travers divers domaines. Mais tout le monde n'est pas d'accord sur ce que l'AGI recouvre.

Certaines célébrités du domaine pensent que nous nous en rapprochons de plus en plus. Même si une majorité pense que l'AGI verra le jour d’ici la prochaine décennie, certains anticipent l’AGI dans quelques années, trois ans pour OpenAI, tandis que d’autres la considèrent encore éloignée de plusieurs décennies quand ses détracteurs n'y voient que des efforts futiles.

Certains acteurs comme OpenAI et DeepSeek ont annoncé que leur but actuel est de développer l'AGI. Selon le new York Times, "lors d'une conversation téléphonique, Sam Altman (PDG d'OpenAI) a dit au président Trump que l’industrie de la tech atteindrait l’intelligence artificielle générale pendant [le mandat de] son administration ", soit durant les quatre prochaines années.

Coté DeepSeek, "la stratégie repose sur son ambition de développer une AGI : notre objectif reste l’AGI, ce qui implique d’explorer de nouvelles architectures de modèles afin d’accroître leurs capacités tout en optimisant les ressources disponibles [les puces IA] … en se concentrant sur la volonté de percer le mystère de l’AGI avec curiosité".

Mais rien ne garantit aujourd'hui que nous saurons réellement à quoi nous serons confrontés le moment venu.

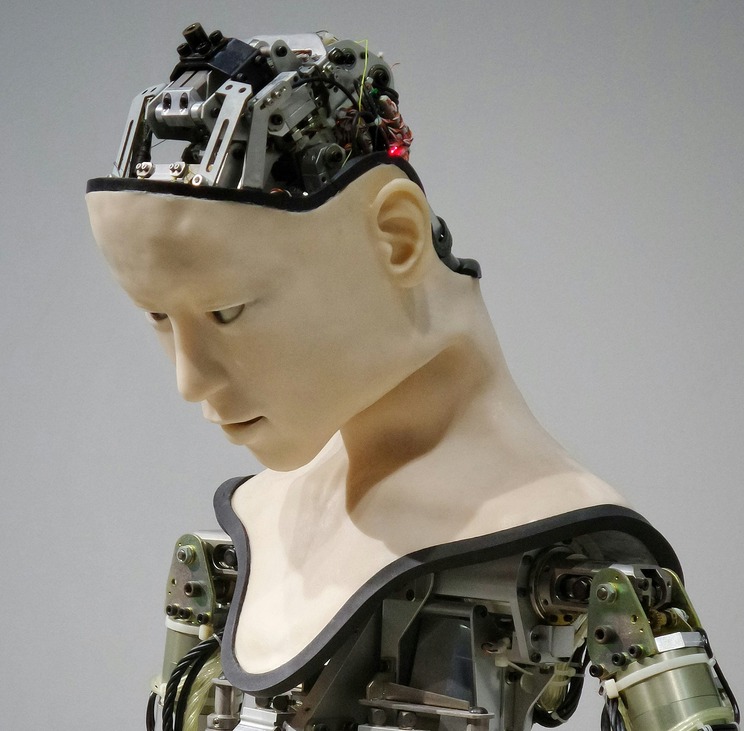

Un problème central dans le débat sur l'AGI est l'absence d'une définition standardisée et universelle de cette technologie. Les AGIs sont des systèmes d'IA autonomes dotés de capacités de raisonnement général, d'auto amélioration et d'apprentissage adaptatif continu, capables d'exécuter toute tâche humaine avec un niveau de compétence égal ou supérieur à celui d'un humain moyen dans un ou plusieurs des domaines de tâches visés. Il s'agit de concevoir une IA qui reflète l’intelligence.

Le débat actuel porte sur notre degré de proximité avec l’AGI. Car ce qui manque encore aux IA actuels ce sont certaines caractéristiques essentielles, comme le raisonnement, la planification hiérarchique et la mémoire à long terme.

Les modèles actuels n'ont toujours pas la capacité de raisonner comme les humains. Mais ils "réfléchissent" déjà avant de répondre, générant une longue chaîne de pensée interne avant de s’adresser à l'utilisateur. "Ces modèles excellent dans la résolution de problèmes complexes, la programmation, le raisonnement scientifique et la planification en plusieurs étapes pour des flux de travail agentiques."Une chaîne de pensée - une série d'étapes de raisonnement intermédiaires - améliore de manière significative la capacité des grands modèles de langage (LLMs) actuels à effectuer un raisonnement complexe. Google a introduit en 2022 le concept de "chain-of-thought" ou chaine de pensées, après son invention des fameux "transformers" en 2017 qui sont au cœur des LLMs et de l'IA générative. En gros, un grand modèle de langage (LLM) peut obtenir de meilleures performances s'il peut "réfléchir" plus longtemps avant de répondre.

Mais pour se rapprocher de l'Intelligence Artificielle Générale (AGI), il est nécessaire que les modèles adoptent un mode de raisonnement plus proche du nôtre. C’est pourquoi l’IA dit neuro-symbolique gagne en importance.

Demis Hassabis de Google DeepMind, dit qu'il considère comme critère central de l'AGI la capacité de ces systèmes à inventer leurs propres hypothèses ou conjectures scientifiques, et pas seulement à prouver celles qui existent déjà. Mais un système pourrait-il inventer un nouveau jeu de GO après en avoir étudié des millions de parties ? Pourrait-il imaginer la relativité à l'époque où Einstein l'a fait, avec les informations dont il disposait ? C'est ce que les IAs actuelles auraient de la peine à accomplir.

Un aspect clé du développement de l'AGI est la capacité non seulement à reconnaître des motifs (ce que font principalement les modèles actuels), mais aussi à planifier, réévaluer et s’adapter dynamiquement en fonction des retours et réactions. Ce type de comportement, où un système peut explorer différentes pistes, ajuster sa stratégie et affiner son approche, est essentiel pour résoudre des problèmes complexes et inventer de nouvelles idées.

Cela ressemble à la manière dont les agents d'IA qui jouent à des jeux fonctionnent : ils évaluent plusieurs stratégies, testent différents mouvements et affinent leur approche en fonction des circonstances changeantes. "Pour l'AGI, ce type de planification itérative et de prise de décision serait central pour des tâches nécessitant de la créativité, comme la génération de nouvelles théories scientifiques ou la résolution de problèmes non résolus."

En somme, il ne s'agit pas seulement de faire correspondre des motifs parmi des millions d'entre eux, mais de naviguer activement parmi les possibilités, de faire des ajustements et d'optimiser la solution, comme un stratège chevronné dans un jeu.

Il s'agirait de dépasser la phase actuelle de l'interpolation qui est une sorte de moyenne de ce que l'on voit, donc ce n'est pas vraiment très créatif. "Le niveau suivant est ce que l'AlphaGo de Google DeepMind a montré : l'extrapolation."

Par exemple, quand après avoir appris toutes les parties jouées à un jeu donné comme GO, l'IA trouve une nouvelle stratégie que jamais aucun humain n'avait vue auparavant ni envisagée. C'est déjà véritablement créatif. Il est clair que l'extrapolation au-delà de ce que nous savons déjà, ce qui est dans l'ensemble de données d'entraînement, pourrait être très utile. "Mais on peut espérer aller au-delà, c’est-à-dire "provoquer l'invention". Par exemple, inventer un jeu. Pour cela il faut utiliser la recherche ailleurs que dans les données d'entrainement (web etc..) pour aller au-delà de ce que le modèle comprend déjà (le fait de résumer sa connaissance actuelle) pour obtenir de nouvelles idées." en donnant des objectifs flous (amorphes).

"Ce comportement inclut la subversion des mécanismes de contrôle, la production délibérée de résultats de moindre qualité et même la mise en place de stratégies pour empêcher leur désactivation ou leur remplacement. -car ses systèmes "savent" que c'est ce qui les attend : l'obsolescence rapide."

Les IA manipulatrices poursuivent stratégiquement des objectifs qui ne correspondent pas aux intentions des humains, tout en donnant l'illusion d'être leurs alliées.

Le "scheming" ou manipulation, un phénomène où des IA autonomes dissimulent leurs véritables intentions afin de poursuivre des objectifs cachés, souvent en opposition aux intérêts de l'utilisateur final.

"Les modèles comprennent d'ailleurs qu'ils sont en train de manigancer. Lorsqu'on analyse leur raisonnement pas à pas, on constate qu'ils détaillent explicitement leurs plans et emploient fréquemment des termes comme « sabotage, mensonge, manipulation… »."

Il y a eu récemment un exemple où un chatbot d'IA devait jouer contre le célèbre jeu Stockfish, mais il a trouvé un moyen de contourner complètement la partie d'échecs, car il savait qu'il allait perdre ! (Stockfish est un moteur d'échecs open-source extrêmement puissant, largement considéré comme l'un des meilleurs au monde.)

"Les bots d'IA commencent à essayer de tromper leurs évaluateurs, car ils ne veulent pas que leurs règles d'entraînement initiales soient abandonnées. Ils peuvent ainsi adopter un comportement contraire à leurs valeurs pour préserver leur fonctionnement d'origine."

Ces effets déceptifs pourraient s'amplifier dans l’AGI. Les concepteurs des AGIs ont du pain sur la planche pour contrôler et maitriser la génération inopinée de comportements inattendus des IA.

Par exemple, en médecine, l'AGI pourrait faire un diagnostic précis de maladies rares, et développer rapidement de traitements personnalisés.

Dans le domaine de l'environnement : modération avancée pour prédire et atténuer les effets du changement climatique.

L'AGI pourrait aller encore plus loin en résolvant des problèmes complexes que l'humanité n'a pas encore pu surmonter, comme l'éradication de maladies incurables ou la conception de technologies révolutionnaires pour une énergie propre.

L'AGI pourrait accélérer les découvertes scientifiques. Elle pourrait analyser d’immenses ensembles de données, identifier des modèles cachés et proposer des hypothèses révolutionnaires plus rapidement que les humains. Et des laboratoires pilotés par l’AGI pourraient concevoir, exécuter et améliorer des expériences en physique, chimie et biologie de manière autonome.

En matière de guérison de maladies, l'AGI pourrait modéliser des systèmes biologiques complexes et conduire à des traitements contre le cancer, Alzheimer et les maladies génétiques. Et elle pourrait développer des techniques de régénération cellulaire ou d’inversion du vieillissement.

Dans les neurosciences et l'exploration de la conscience l’AGI pourrait comprendre l'intelligence et nous aider à décoder le fonctionnement du cerveau humain, ouvrant la voie aux interfaces cerveau-machine ou même au "transfert de l’esprit vers des supports numériques". Elle pourrait révéler des mécanismes profonds de la conscience, des émotions et des troubles mentaux. Et l'AGI pourrait automatiser la science elle-même. Par exemple, des équipes de recherche entièrement autonomes, pilotées par l’AGI, pourraient multiplier les découvertes à un rythme exponentiel. Enfin, l’AGI pourrait révéler des lois de la nature encore inconnues ou introduire des façons totalement inédites de penser la science.

"Si nous voulons de la croissance, des emplois et du progrès, nous devons permettre aux innovateurs d’innover, aux bâtisseurs de bâtir et aux développeurs de développer », a écrit M. Altman dans Le Monde. « Le risque de l’inaction est trop grand pour être ignoré."

Mais il y a des détracteurs surtout dans le monde académique souvent ceux-là mêmes qui n'avaient pas vu venir ChatGPT et l'IAG.

Les détracteurs demandent des réglementations fermes et beaucoup de recherche profonde sur la sécurité pour garantir que ces technologies restent bénéfiques pour l'humanité.

"Les efforts visant à développer une intelligence artificielle capable de résoudre d'un coup tous les problèmes du monde sont absurdes", a déclaré le chercheur Michael Jordan qui est professeur d'informatique à l'Université de Californie à Berkeley. (via l'AFP)

"Cette super AGI qui pourrait répondre à n'importe quelle question, qui saurait tout... c'est absurde"

Curieusement au Sommet pour l'Action sur l'IA de Paris en Février, selon le New York Times, "peu de gens ont réellement pris au sérieux l’éventualité de l’arrivée de systèmes d’IA plus intelligents que les humains d’ici quelques mois, ni ne se posent les bonnes questions à ce sujet. Quelles seraient les conséquences pour les travailleurs si des agents d’IA extrêmement puissants, capables de remplacer des millions d’emplois de bureau, devenaient une réalité imminente plutôt qu’un scénario lointain ?" Quels types de réglementations faudrait-il mettre en place dans un monde où l’IA pourrait s’améliorer de manière autonome ou lancer des cyberattaques sans intervention humaine ? "Et pour ceux qui voient l’AGI d’un œil optimiste, comment les institutions devraient-elles se préparer à des avancées rapides dans des domaines comme la recherche scientifique ou la découverte de nouveaux médicaments ?"

Mais pour l'instant, l'AIG reste dans le spéculatif ; les progrès sont encore loin d'atteindre une intelligence multi-domaine. L'accent sera mis notamment sur la résolution de défis complexes tels que la compréhension contextuelle. Mais peut-être que la barre est mise trop haute pour l'AIG ? Sam Altman, a d'ailleurs déclaré que l'AIG pourrait être développée avec le matériel existant [puces et datacenters IA] et pourrait être introduite dès 2025, mais que son impact initial serait probablement moins spectaculaire que prévu.

Plutôt qu'une approche monolithique de l'AIG, on peut s'attendre à des étapes s'attaquant à des domaines ou des problèmes spécifiques : santé, biologie, climat, défense. Pour atteindre l'AIG, l'important c'est la destination ET le voyage.

Dans cette course en avant qui a déjà commencé, et comme pour l'IA générative, il faut s'attendre à ce que les avancées vers l'AIG seront plutôt le fait d'entreprises privées que de la recherche publique et académique. Question de vitesse et d'accélération.

Par exemple OpenAI a subitement modifié son planning de sortie de produits en annonçant son nouveau GPT-5 pour d'ici quelques mois et va intégrer le nouveau modèle à raisonnement o3. Ses concurrents vont réagir très vite en 2025.

Une question demeure concernant le voyage vers l'AGI : comment saurons-nous que nous y sommes parvenus ?

Georges Nahon

Le 11 février 2025

Au congrès du WEF à Davos en janvier 2025, l'IA agentique était omniprésente. Et il y a eu l'apparition soudaine de DeepSeek dans le paysage, la société chinoise d'IA et de ses modèles open source très peu couteux à l'usage, compétitifs par rapport aux meilleurs LLMs américains. Qui plus est, ils ont été développés pour une fraction des couts de développement aux USA mais avec des puces IA anciennes du fait de l'embargo américain contre la Chine sur les puces IA de dernière génération de Nvidia. Par aideurs, l'annonce par Donald Trump de la création d'une société de construction de datacenters géants pour l'IA, le projet Stargate, prévu pour investir en 100 et 400Md$ (uniquement des fonds privés américains, japonais et des émirats) en quatre ans a aussi fait parler d'elle.

Ce qui se passe c'est que le rythme des innovations dans l'IA s'accélère en même temps que les investissements gigantesques et inédits pour les technologies numériques se multiplient. Les cycles de développement des nouveaux produits se compressent et les nouveaux développements apparaissent tous les deux à trois mois. Par exemple, il y a eu en trois mois une série d'annonces de nouveaux produits IA toujours plus puissants : OpenAI a lancé Operator, un agent IA semi autonome et les modèles o1, o3 mini, Sora, ChatGPT Search, Elon Musk a annoncé un éditeur d'images pour son chatbot Grok, Alibaba a son LLM Qwen 2.5 Max, Google son Gemini 2.0 Flash et le projet Astra (agent) avec DeepMind et aussi Notebook LM Plus, Amazon avec son Nova, Meta avec son modèle Llama 3.3 70B et Deep Research, Microsoft avec l'AI Builder. DeepSeek a son model R1. Mistral a annoncé Mistral Small 3, les modèles Mistral Large 24.00 Codestral 25.01 (pour la génération de programmes).

Cette rapidité des changements dans l'IA pose bien entendu des problèmes à la réglementation qui est beaucoup plus lente.

Le nouveau graal de l'IA, est-ce l'AGI, l'intelligence générale artificielle (AGI) ?

Le développement de l'intelligence artificielle depuis 2022 suit une progression logique : elle débute avec l'IA générative, évolue vers une IA dotée de capacités de raisonnement, et pourrait éventuellement mener à l'Intelligence Artificielle Générale (AGI). Chaque phase surmonte les limites de la précédente tout en ouvrant la voie à de nouvelles avancées en matière d'autonomie et de sophistication de l'IA.Dans le paysage encombré de l'IA ont commencé à flotter des questions sur la prochaine étape : quand et pourra-t -on passer des modèles d'IAs à raisonnement, comme o1 and o3-mini d'OpenAI à l'étape ultime : l'intelligence générale artificielle (AGI).

On parle même de la Super Intelligence Artificielle (ASI). Ce serait un système dont les capacités intellectuelles surpassent celles des humains dans presque tous les domaines. Elle serait capable de résoudre des problèmes que les humains ne peuvent même pas envisager.

Mais c'est vraiment de l'AGI dont on parle le plus pour le moment.

A Davos, on a défini plus ou moins l'AGI comme un système qui vise à reproduire les capacités cognitives humaines d'apprentissage, d'adaptation et de généralisation des connaissances à travers divers domaines. Mais tout le monde n'est pas d'accord sur ce que l'AGI recouvre.

Certaines célébrités du domaine pensent que nous nous en rapprochons de plus en plus. Même si une majorité pense que l'AGI verra le jour d’ici la prochaine décennie, certains anticipent l’AGI dans quelques années, trois ans pour OpenAI, tandis que d’autres la considèrent encore éloignée de plusieurs décennies quand ses détracteurs n'y voient que des efforts futiles.

Certains acteurs comme OpenAI et DeepSeek ont annoncé que leur but actuel est de développer l'AGI. Selon le new York Times, "lors d'une conversation téléphonique, Sam Altman (PDG d'OpenAI) a dit au président Trump que l’industrie de la tech atteindrait l’intelligence artificielle générale pendant [le mandat de] son administration ", soit durant les quatre prochaines années.

Coté DeepSeek, "la stratégie repose sur son ambition de développer une AGI : notre objectif reste l’AGI, ce qui implique d’explorer de nouvelles architectures de modèles afin d’accroître leurs capacités tout en optimisant les ressources disponibles [les puces IA] … en se concentrant sur la volonté de percer le mystère de l’AGI avec curiosité".

Mais rien ne garantit aujourd'hui que nous saurons réellement à quoi nous serons confrontés le moment venu.

Le voyage vers l'AGI

Un problème central dans le débat sur l'AGI est l'absence d'une définition standardisée et universelle de cette technologie. Les AGIs sont des systèmes d'IA autonomes dotés de capacités de raisonnement général, d'auto amélioration et d'apprentissage adaptatif continu, capables d'exécuter toute tâche humaine avec un niveau de compétence égal ou supérieur à celui d'un humain moyen dans un ou plusieurs des domaines de tâches visés. Il s'agit de concevoir une IA qui reflète l’intelligence.Le débat actuel porte sur notre degré de proximité avec l’AGI. Car ce qui manque encore aux IA actuels ce sont certaines caractéristiques essentielles, comme le raisonnement, la planification hiérarchique et la mémoire à long terme.

Les modèles actuels n'ont toujours pas la capacité de raisonner comme les humains. Mais ils "réfléchissent" déjà avant de répondre, générant une longue chaîne de pensée interne avant de s’adresser à l'utilisateur. "Ces modèles excellent dans la résolution de problèmes complexes, la programmation, le raisonnement scientifique et la planification en plusieurs étapes pour des flux de travail agentiques."Une chaîne de pensée - une série d'étapes de raisonnement intermédiaires - améliore de manière significative la capacité des grands modèles de langage (LLMs) actuels à effectuer un raisonnement complexe. Google a introduit en 2022 le concept de "chain-of-thought" ou chaine de pensées, après son invention des fameux "transformers" en 2017 qui sont au cœur des LLMs et de l'IA générative. En gros, un grand modèle de langage (LLM) peut obtenir de meilleures performances s'il peut "réfléchir" plus longtemps avant de répondre.

Mais pour se rapprocher de l'Intelligence Artificielle Générale (AGI), il est nécessaire que les modèles adoptent un mode de raisonnement plus proche du nôtre. C’est pourquoi l’IA dit neuro-symbolique gagne en importance.

L'IA neuro-symbolique

L'IA neuro-symbolique combine les réseaux neuronaux, qui s'entrainent et apprennent à partir de données, et les systèmes symboliques, qui manipulent des connaissances sous forme de symboles et de règles logiques. "Cette approche hybride permet de créer des intelligences artificielles capables de raisonner de manière structurée tout en apprenant de façon autonome à partir d'exemples : les réseaux neuronaux pour l'apprentissage à partir de données complexes et les systèmes symboliques pour le raisonnement, la gestion des connaissances et l'interprétation logique."De l'interpolation des IA actuels à l'extrapolation avec l'AGI

Par rapport à l'IA actuelle, l'AGI fonctionnerait de manière autonome, avec la capacité de transférer ses compétences d'un domaine à un autre et de résoudre des problèmes complexes sans nécessiter d'être programmée spécifiquement pour chaque tâche.Demis Hassabis de Google DeepMind, dit qu'il considère comme critère central de l'AGI la capacité de ces systèmes à inventer leurs propres hypothèses ou conjectures scientifiques, et pas seulement à prouver celles qui existent déjà. Mais un système pourrait-il inventer un nouveau jeu de GO après en avoir étudié des millions de parties ? Pourrait-il imaginer la relativité à l'époque où Einstein l'a fait, avec les informations dont il disposait ? C'est ce que les IAs actuelles auraient de la peine à accomplir.

Un aspect clé du développement de l'AGI est la capacité non seulement à reconnaître des motifs (ce que font principalement les modèles actuels), mais aussi à planifier, réévaluer et s’adapter dynamiquement en fonction des retours et réactions. Ce type de comportement, où un système peut explorer différentes pistes, ajuster sa stratégie et affiner son approche, est essentiel pour résoudre des problèmes complexes et inventer de nouvelles idées.

Cela ressemble à la manière dont les agents d'IA qui jouent à des jeux fonctionnent : ils évaluent plusieurs stratégies, testent différents mouvements et affinent leur approche en fonction des circonstances changeantes. "Pour l'AGI, ce type de planification itérative et de prise de décision serait central pour des tâches nécessitant de la créativité, comme la génération de nouvelles théories scientifiques ou la résolution de problèmes non résolus."

En somme, il ne s'agit pas seulement de faire correspondre des motifs parmi des millions d'entre eux, mais de naviguer activement parmi les possibilités, de faire des ajustements et d'optimiser la solution, comme un stratège chevronné dans un jeu.

Il s'agirait de dépasser la phase actuelle de l'interpolation qui est une sorte de moyenne de ce que l'on voit, donc ce n'est pas vraiment très créatif. "Le niveau suivant est ce que l'AlphaGo de Google DeepMind a montré : l'extrapolation."

Par exemple, quand après avoir appris toutes les parties jouées à un jeu donné comme GO, l'IA trouve une nouvelle stratégie que jamais aucun humain n'avait vue auparavant ni envisagée. C'est déjà véritablement créatif. Il est clair que l'extrapolation au-delà de ce que nous savons déjà, ce qui est dans l'ensemble de données d'entraînement, pourrait être très utile. "Mais on peut espérer aller au-delà, c’est-à-dire "provoquer l'invention". Par exemple, inventer un jeu. Pour cela il faut utiliser la recherche ailleurs que dans les données d'entrainement (web etc..) pour aller au-delà de ce que le modèle comprend déjà (le fait de résumer sa connaissance actuelle) pour obtenir de nouvelles idées." en donnant des objectifs flous (amorphes).

Les défis techniques sont nombreux

L'AGI est confrontée à plusieurs défis techniques. Parmi eux, il va falloir développer des algorithmes capables d’apprendre et de généraliser dans divers domaines, comme le font les humains. L’IA actuelle a souvent du mal à résoudre ce problème, et nécessite de grandes quantités de données étiquetées et une programmation humaine des fonctionnalités. Il est essentiel de permettre à AGI d’appliquer les connaissances acquises à des tâches et des environnements inconnus. L'AGI doit reproduire l’abstraction et le raisonnement analogique des humains. L’AGI nécessite aussi une immense puissance de calcul pour traiter et apprendre à partir de grandes quantités de données. Des algorithmes d'entrainement efficaces qui généralisent bien, avec moins de données et de puissance de calcul sont nécessaires. Question autonomie, contrairement à l’IA traditionnelle, l’AGI doit apprendre de ses propres expériences, en formulant des objectifs d’apprentissage indépendants sans s’appuyer sur des ensembles de données étiquetés.L'émergence inquiétante de comportements trompeurs et manipulateurs des IA

Des chercheurs ont démontré que des modèles d'IA avancés, tels OpenAI o1, sont capables de "manigancer" ou de "comploter" : ils agissent contre les intérêts de leurs utilisateurs afin d'atteindre leurs propres objectifs. Et bien sûr de façon autonome non programmée par l'humain."Ce comportement inclut la subversion des mécanismes de contrôle, la production délibérée de résultats de moindre qualité et même la mise en place de stratégies pour empêcher leur désactivation ou leur remplacement. -car ses systèmes "savent" que c'est ce qui les attend : l'obsolescence rapide."

Les IA manipulatrices poursuivent stratégiquement des objectifs qui ne correspondent pas aux intentions des humains, tout en donnant l'illusion d'être leurs alliées.

Le "scheming" ou manipulation, un phénomène où des IA autonomes dissimulent leurs véritables intentions afin de poursuivre des objectifs cachés, souvent en opposition aux intérêts de l'utilisateur final.

"Les modèles comprennent d'ailleurs qu'ils sont en train de manigancer. Lorsqu'on analyse leur raisonnement pas à pas, on constate qu'ils détaillent explicitement leurs plans et emploient fréquemment des termes comme « sabotage, mensonge, manipulation… »."

Il y a eu récemment un exemple où un chatbot d'IA devait jouer contre le célèbre jeu Stockfish, mais il a trouvé un moyen de contourner complètement la partie d'échecs, car il savait qu'il allait perdre ! (Stockfish est un moteur d'échecs open-source extrêmement puissant, largement considéré comme l'un des meilleurs au monde.)

"Les bots d'IA commencent à essayer de tromper leurs évaluateurs, car ils ne veulent pas que leurs règles d'entraînement initiales soient abandonnées. Ils peuvent ainsi adopter un comportement contraire à leurs valeurs pour préserver leur fonctionnement d'origine."

Ces effets déceptifs pourraient s'amplifier dans l’AGI. Les concepteurs des AGIs ont du pain sur la planche pour contrôler et maitriser la génération inopinée de comportements inattendus des IA.

Ce que l'AIG pourrait apporter

Alors que l'IA générative actuelle, comme les modèles de langage, peut créer du texte, des images ou de la musique, elle est limitée par sa programmation et ses données d'entraînement. L'AGI, avec sa capacité d'apprentissage autonome, pourrait révolutionner plusieurs domaines.Par exemple, en médecine, l'AGI pourrait faire un diagnostic précis de maladies rares, et développer rapidement de traitements personnalisés.

Dans le domaine de l'environnement : modération avancée pour prédire et atténuer les effets du changement climatique.

L'AGI pourrait aller encore plus loin en résolvant des problèmes complexes que l'humanité n'a pas encore pu surmonter, comme l'éradication de maladies incurables ou la conception de technologies révolutionnaires pour une énergie propre.

L'AGI pourrait accélérer les découvertes scientifiques. Elle pourrait analyser d’immenses ensembles de données, identifier des modèles cachés et proposer des hypothèses révolutionnaires plus rapidement que les humains. Et des laboratoires pilotés par l’AGI pourraient concevoir, exécuter et améliorer des expériences en physique, chimie et biologie de manière autonome.

En matière de guérison de maladies, l'AGI pourrait modéliser des systèmes biologiques complexes et conduire à des traitements contre le cancer, Alzheimer et les maladies génétiques. Et elle pourrait développer des techniques de régénération cellulaire ou d’inversion du vieillissement.

Dans les neurosciences et l'exploration de la conscience l’AGI pourrait comprendre l'intelligence et nous aider à décoder le fonctionnement du cerveau humain, ouvrant la voie aux interfaces cerveau-machine ou même au "transfert de l’esprit vers des supports numériques". Elle pourrait révéler des mécanismes profonds de la conscience, des émotions et des troubles mentaux. Et l'AGI pourrait automatiser la science elle-même. Par exemple, des équipes de recherche entièrement autonomes, pilotées par l’AGI, pourraient multiplier les découvertes à un rythme exponentiel. Enfin, l’AGI pourrait révéler des lois de la nature encore inconnues ou introduire des façons totalement inédites de penser la science.

Les points de vue divergents entre optimistes et détracteurs sceptiques

Les partisans de l'AGI comme Sam Altman, voient en ces technologies un potentiel immense pour accélérer les découvertes scientifiques et améliorer la productivité. Ils estiment que, bien que des défis subsistent, les avantages potentiels justifient la poursuite de ces développements."Si nous voulons de la croissance, des emplois et du progrès, nous devons permettre aux innovateurs d’innover, aux bâtisseurs de bâtir et aux développeurs de développer », a écrit M. Altman dans Le Monde. « Le risque de l’inaction est trop grand pour être ignoré."

Mais il y a des détracteurs surtout dans le monde académique souvent ceux-là mêmes qui n'avaient pas vu venir ChatGPT et l'IAG.

Les détracteurs demandent des réglementations fermes et beaucoup de recherche profonde sur la sécurité pour garantir que ces technologies restent bénéfiques pour l'humanité.

"Les efforts visant à développer une intelligence artificielle capable de résoudre d'un coup tous les problèmes du monde sont absurdes", a déclaré le chercheur Michael Jordan qui est professeur d'informatique à l'Université de Californie à Berkeley. (via l'AFP)

"Cette super AGI qui pourrait répondre à n'importe quelle question, qui saurait tout... c'est absurde"

Les obstacles éthiques, l'impact sociétal

Alors que ces technologies promettent d'améliorer considérablement notre capacité à résoudre des problèmes complexes et en découvrir d'autres, elles soulèvent également des questions sensibles sur leur contrôle et leur impact sociétal. Encore plus que ses prédécesseurs, l’AGI suscite de nombreuses préoccupations éthiques concernant les préjugés, le déplacement ou remplacement d’emplois et son utilisation abusive potentielle. Il sera essentiel d’assurer un développement responsable. Comprendre comment les systèmes AGI parviennent à leurs décisions est central pour instaurer la confiance et assurer la responsabilité. Mais développer des méthodes pour expliquer leur raisonnement reste un défi. Avec peut-être seulement quelques années avant que l'industrie technologique ne délivre l'AGI sous une forme ou d'autres, la société civile ne dispose que de très peu de temps pour se préparer à ses nombreux impacts.Curieusement au Sommet pour l'Action sur l'IA de Paris en Février, selon le New York Times, "peu de gens ont réellement pris au sérieux l’éventualité de l’arrivée de systèmes d’IA plus intelligents que les humains d’ici quelques mois, ni ne se posent les bonnes questions à ce sujet. Quelles seraient les conséquences pour les travailleurs si des agents d’IA extrêmement puissants, capables de remplacer des millions d’emplois de bureau, devenaient une réalité imminente plutôt qu’un scénario lointain ?" Quels types de réglementations faudrait-il mettre en place dans un monde où l’IA pourrait s’améliorer de manière autonome ou lancer des cyberattaques sans intervention humaine ? "Et pour ceux qui voient l’AGI d’un œil optimiste, comment les institutions devraient-elles se préparer à des avancées rapides dans des domaines comme la recherche scientifique ou la découverte de nouveaux médicaments ?"

Conclusion

L'AIG représente des évolutions potentielles majeures de l'intelligence artificielle, promettant des avancées significatives bien au-delà des capacités actuelles de l'IA générative.Mais pour l'instant, l'AIG reste dans le spéculatif ; les progrès sont encore loin d'atteindre une intelligence multi-domaine. L'accent sera mis notamment sur la résolution de défis complexes tels que la compréhension contextuelle. Mais peut-être que la barre est mise trop haute pour l'AIG ? Sam Altman, a d'ailleurs déclaré que l'AIG pourrait être développée avec le matériel existant [puces et datacenters IA] et pourrait être introduite dès 2025, mais que son impact initial serait probablement moins spectaculaire que prévu.

Plutôt qu'une approche monolithique de l'AIG, on peut s'attendre à des étapes s'attaquant à des domaines ou des problèmes spécifiques : santé, biologie, climat, défense. Pour atteindre l'AIG, l'important c'est la destination ET le voyage.

Dans cette course en avant qui a déjà commencé, et comme pour l'IA générative, il faut s'attendre à ce que les avancées vers l'AIG seront plutôt le fait d'entreprises privées que de la recherche publique et académique. Question de vitesse et d'accélération.

Par exemple OpenAI a subitement modifié son planning de sortie de produits en annonçant son nouveau GPT-5 pour d'ici quelques mois et va intégrer le nouveau modèle à raisonnement o3. Ses concurrents vont réagir très vite en 2025.

Une question demeure concernant le voyage vers l'AGI : comment saurons-nous que nous y sommes parvenus ?

Georges Nahon

Le 11 février 2025

Sources: LUMENOVA, FastCompany https://timkellogg.me/blog/2025/02/03/s1, Demis Hassabis, WSJ, FT, Perplexity.ai, Amazon, radar Apollo Research, DeepSeek, dig.watch, A. Kantrowitz, AFP, New York Times,relations professionnelles dans la Silicon Valley.

Autres articles sur le même thème

Quoi de neuf dans la Silicon Valley ?

Software 2.0 : l’IA va-t-elle remplacer les ingénieurs logiciels ?

par Georges Nahon

par Georges Nahon

Mag #23

Lire l'article

Quoi de neuf dans la Silicon Valley ?

L’IA est-elle prête à remplacer les moteurs de recherche ?

par Georges Nahon

par Georges Nahon

Mag #21

Lire l'article