Quoi de neuf dans la Silicon Valley ?

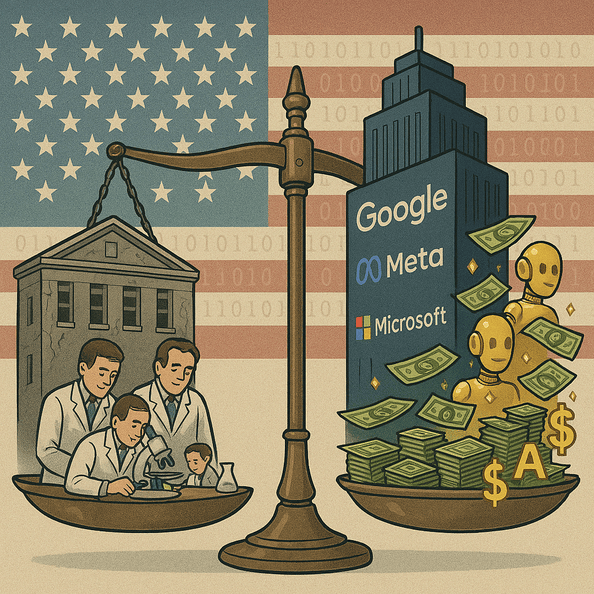

La privatisation de la recherche dans l'IA aux Etats Unispar Georges Nahon

Retour

L'annonce du départ en mai 2025 de Joëlle Pineau, la directrice de la recherche en IA de Meta a attiré l'attention du Wall Street Journal. Ce qui souligne l’importance de l'événement dans le monde de la tech. Les grands médias se concentrent sur ce genre de départs, non seulement en raison de la personne concernée, mais aussi en raison des implications plus larges pour l’entreprise et le secteur d'activité en général. Cela met aussi l'accent sur l'importance de la recherche dans l'IA dans le secteur privé et notamment chez les Big IA américaines comme Microsoft, Google, Apple, Meta, Amazone, Nvidia, xAI d'Elon Musk pour citer les principales.

Mais certains ont été réintégrés par Google notamment les deux fondateurs de la startup Character.AI, Noam Shazeer et Daniel De Freitas. De même, l'ancien cofondateur de DeepMind société britannique d'IA acquise par Google, M.Suleyman était devenu PDG et cofondateur d’Inflection AI. Il est maintenant CEO de Microsoft AI.

L'exode en peu de temps d'une dizaine de célébrités d'OpenAi a été la plus marquante : Ilya Sutskever, cofondateur et ancien scientifique en chef d’OpenAI. Andrej Karpathy, cofondateur et chercheur influent dans des domaines tels que la vision par ordinateur et la modélisation générative, Mira Murati, la CTO, directrice de la technologie d’OpenAI, Bob McGrew, directeur de la recherche Barret Zoph, Vice-Président de la recherche et Dario Amodei, Ancien vice-président de la recherche. Il est parti fin 2020 pour cofonder Anthropic, une société de recherche et de sécurité sur l’IA.

Mais le "AI Brain Drain", la fuite des cerveaux académiques de l'IA vers le privé, n'est pas spectaculaire par rapport au besoin très important de talents dans cette discipline dans le privé. Cela ne se traduit pas encore par un grand "Brain Gain", ou gain de talents pour le privé.

Deux ou trois scientifiques renommés de l'ère précédente de l'IA sont effectivement passés du monde universitaire au privé. Quelques-uns comme madame Fei-Fei Li, professeur à Stanford dans l'IA, a fait un passage à Google Cloud pour ensuite revenir à son université. Il y eu quelques noms célèbres comme Demis Hassabis co-fondateur de DeepMind, Ian Goodfellow de Stanford inventeur des GAN, réseaux antagonistes génératifs. Et quelques autres.

En revanche les récents diplômés en IA aux Etats-Unis partent en grand nombre vers le privé et ne poursuivent donc pas de recherche dans le monde universitaire. Des 2021 ce phénomène était signalé et étudié : "Nos résultats [] soutiennent l’idée d’un flux croissant de talents allant du milieu universitaire vers l’industrie, ce qui pourrait nécessiter l’attention des décideurs politiques" ont indiqué les quatre chercheurs auteurs d'un rapport sur le sujet. Selon eux, la raison pour laquelle les décideurs politiques devraient s’inquiéter de tels changements est que les entreprises privées risquent de ne pas donner la priorité nécessaire aux préoccupations éthiques et sociales concernant l'IA.

Une statistique récente du AI Index report 2025 de Stanford montre qu'en 2010 44% des titulaires de doctorats (PhDs) étaient partis dans le privé et que ce nombre serait de 76% en Amérique du Nord en 2024. Cette tendance met en évidence un changement dynamique où l’expertise universitaire est de plus en plus canalisée vers des initiatives du secteur privé.

De nombreux chercheurs en IA de haut niveau sont passés de l’université à des laboratoires d’entreprise pour obtenir un meilleur salaire, des outils de pointe et la possibilité de travailler sur des projets ambitieux destinés à être confrontés rapidement avec le marché. Des laboratoires comme DeepMind de Google et Anthropic attirent des docteurs du MIT, de Stanford et d’autres universités américaines de premier plan.

Selon le "Artificial Intelligence Index Report 2025 de Stanford", le secteur privé continue de dominer la recherche de pointe sur l’IA. Près de 90 % des modèles d’IA notables en 2024 provenaient de l’industrie, contre 60 % en 2023, tandis que le milieu universitaire reste la principale source de recherches les plus citées du fait d'un focus plus fort que le privé sur les publications. Pour l'IA, les laboratoires privés avancent plus vite que le monde universitaire car ils sont moins encombrés dans leurs activités par les retards dans l’évaluation de leurs travaux par leurs pairs académiques dans l'objectif de publier. Idem pour le financement de leurs travaux par les longs cycles d'obtention de subventions ou de dotations publiques ou privés bien moindres que dans le privé par ailleurs. Dans le privé, les chercheurs peuvent passer de l’idée à la mise en œuvre en quelques semaines ou mois. Et non des années. Pour ce qui est des publications, il existe des différences notables entre la recherche en IA dans les secteurs privé et public. Les chercheurs en IA de l'industrie sont généralement cités deux fois plus que leurs homologues académiques, mais publient moins fréquemment. Mais en parallèle, ces chercheurs semblent atteindre une forme de stagnation académique, ce qui indique que leurs employeurs privilégient davantage la mise en œuvre d'idées éprouvées plutôt que l'exploration de nouvelles approches novatrices. Le rôle de la recherche à long terme plutôt du ressort universitaire trouve bien sa place dans ce contexte.

Un rapport récent de l'AAAI, l'association pour le progrès de l'intelligence artificielle aux Etats Unis, apporte un éclairage précis sur la concurrence privé/académique pour ce qui est de la recherche en AI.

"Le centre de gravité de la recherche en IA se trouve maintenant derrière les portes closes des grandes entreprises technologiques." Les universités ne peuvent pas rivaliser avec elles pour ce qui est des ressources disponibles : données, puissances de calcul et salaires. Les universités américaines ont du mal à retenir les professeurs d’IA et à persuader les diplômés en IA de rester dans le milieu universitaire. L’enjeu est donc maintenant de trouver un rôle pour le monde académique (et la recherche financée par des fonds publics) dans la nouvelle ère de la « big AI », c'est à dire les Big Tech de l'IA (Google/Alphabet, Microsoft, Meta, Amazon, Apple, Nvidia, OpenAI…).

La plupart des répondants à l'enquête menée dans cette étude, (environ 75 %) ont convenu que les universités ont des difficultés à recruter dans le domaine de l’IA et qu'elles ont du mal à s’engager dans des recherches sur l’IA qui demandent beaucoup de ressources (80 %). Il y avait moins d’accord sur la nécessité pour les universités de recentrer leurs priorités de recherche, bien qu’il semble que les répondants estiment que le fait de se concentrer sur l’IA théorique et l’IA multidisciplinaire sont des domaines où les universités pourraient être compétitives.

Il ne s’agit pas seulement de la question de l'accès à des ressources hors de portée des laboratoires universitaires. Il existe des différences significatives d’état d’esprit et de priorités entre le monde universitaire et le monde commercial aux Etats-Unis qui expliquent en partie pourquoi les laboratoires privés sont souvent à l’avant-garde de la mise sur le marché de l’IA générative (et d’autres technologies de la même famille).

Dans le milieu universitaire, même si les chercheurs s'intéressent évidemment aux nouvelles technologies numériques, ils mettent souvent plus de temps à envisager leur potentiel commercial et à adapter leurs recherches en conséquence car ce n'est pas leur priorité. lls se concentrent davantage sur la théorie que sur les applications concrètes immédiates de leurs travaux.

Comme disait un ingénieur facétieux, la théorie c'est ce qui n'est pas pratique !

Alors que dans le privé, les entreprises ont des équipes spécialisées de veille et des investisseurs qui recherchent en permanence les prochaines innovations prometteuses. Ainsi, elles repèrent et financent plus vite les recherches et travaux sur des technologies à fort potentiel commercial.

C'est pourquoi quelques chercheurs en IA de haut niveau sont passés de l’université à des laboratoires d’entreprise pour avoir la possibilité de travailler sur des projets ambitieux et proches d'une implémentation réelle pour confronter la réalité et ses exigences. Mais il y a une bonne coopération entre les mondes universitaires et privés pour ce qui est de la famille de l'IA au sens large.

Pourquoi de nombreux chercheurs académiques ont-ils été pris de court par l’essor soudain de l’IA générative (GenIA) comme ChatGPT, même si les fondations étaient en gestation depuis des années (ou des décennies). Pour être fairplay, même certaines entreprises Big Tech comme Google, Meta et Apple ont également donné l'impression d'être prises par surprise mais quand même beaucoup mieux préparées à répliquer et revenir dans le jeu mené par OpenAI. Avec le soutien financier et opérationnel de Microsoft.

Mais cet incident est indicatif de l'écart qui règne entre les motivations de la recherche académique dans l'IA et celle menée dans le privé.

Le focus des chercheurs était des indicateurs techniques, pas l’expérience utilisateur

Les chercheurs évaluaient les modèles selon des mesures académiques (précision, perplexité, scores BLEU pour les traductions...), mais pas selon leur utilité concrète pour les gens. ChatGPT a réussi pas parce qu'il dépassait les benchmarks académiques, mais parce qu'il était à facile utiliser dans un mode conversationnel compris de tous, rapide, novateur et un peu magique. Et sommes toutes, suffisamment bon (good enough) sans être parfait dans de nombreux domaines pour séduire les masses.

Ce seuil "assez bon" s’est avéré être plus révolutionnaire qu’une précision parfaite.

Effet de surprise devant la "productisation" rapide et le passage ultrarapide à une échelle colossale

OpenAI a entraîné ses modèles (comme GPT-3 et GPT-4) à une échelle gigantesque, bien au-delà des capacités de la plupart des laboratoires académiques. Les chercheurs n’avaient pas accès à autant de puissance de calcul ni à autant de données. En conséquence, et sans suffisamment de recul, ils ne pouvaient pas anticiper l’impact qu’un modèle aussi grand et si bien affiné pourrait avoir sur le grand public qui a rapidement trouvé l'intérêt de ces chatbots que les moteurs de recherche ni Wikipédia ne pouvaient pas concurrencer.

Sous-estimation des comportements émergents des utilisateurs

Beaucoup pensaient que les grands modèles de langage allaient seulement faire de l'auto-complétion de textes de manière un peu plus fluide que ce qui était connu. Ce qui a surpris, c’est l’apparition de compétences inattendues : "raisonnement", traduction, codage/programmation, humour, résolution de problèmes simples.

Ces capacités n’étaient pas explicitement programmées, elles ont émergé spontanément avec le passage à l'échelle — un phénomène mal compris à l’époque.

Une communauté de recherche dans l'IA fragmentée

Le monde de l’IA est vaste. Certains chercheurs se spécialisent dans des domaines comme la vision par ordinateur, la robotique, les neurosciences, l'IA symbolique, l'éthique.

Ceux en dehors du domaine du traitement du langage naturel (NLP) n’ont parfois pas suivi les avancées des transformers et des LLMs inventés par Google et OpenAI essentiellement. Même au sein du NLP, le saut entre GPT-2 et ChatGPT a été un choc.

Pas d'accès pour les gens de l'extérieur aux développements faits dans les entreprises

Une grande partie des travaux les plus avancés (par exemple, GPT-3, ChatGPT, Claude, Gemini) provenaient d’entreprises privées, et non d’universités. Les détails de ces LLMs n’étaient pas toujours publics, de sorte que les chercheurs universitaires étaient souvent en train de rattraper leur retard quand ces LLMs étaient révélés, ou ne savaient pas à quel point la technologie avait avancé jusqu’à ce qu’elle soit ouverte au public.

Mauvaise appréciation des réactions humaines

Les chercheurs académiques ont peut-être aussi sous-estimé la façon dont le publique réagirait à un chatbot qui avait l'air intelligent, utile, facile à utiliser et un peu magique. Le facteur « wow » d'admiration/surprise suscité par le fait de pouvoir "parler" à une machine qui répond comme un humain a été sous-estimé par de nombreux universitaires.

Selon plusieurs observateurs, l'IA est en train de redéfinir ce que signifie être un chercheur, tant dans la manière dont la recherche est menée que dans la façon dont les chercheurs définissent leurs rôles. Ce changement se produit de plusieurs façons.

Accélération de la découverte

Les outils d'IA peuvent traiter des ensembles de données massifs bien plus rapidement que les humains, découvrant ainsi des modèles, des tendances ou des anomalies qui prendraient des semaines ou des mois à identifier manuellement. Ceci permet aux chercheurs de se concentrer davantage sur l'interprétation des résultats que sur leur recherche.

Passage de la collecte de données à l'interprétation des données

Traditionnellement, les chercheurs passent beaucoup de temps à collecter et organiser des données. L'IA automatise une grande partie de ce processus (par exemple, le web scraping ou récupération de données du web, le nettoyage des données, les simulations d'expériences), permettant aux chercheurs de se concentrer sur l'analyse, la construction de théories et l'application des connaissances acquises.

Redéfinir l'expertise

L'IA permet à des personnes, sans connaissances approfondies dans un domaine, de réaliser rapidement des analyses avancées en utilisant des modèles pré-entrainés ou des interfaces accessibles comme ChatGPT. Cela démocratise la recherche, mais remet aussi en question les notions d'expertise et d'autorité dans un domaine donné.

Améliorer la collaboration

L'IA facilite le travail interdisciplinaire en assurant la traduction entre les différents domaines (par exemple, en aidant un biologiste à comprendre des termes de l'informatique ou inversement). Elle permet également aux équipes mondiales de travailler plus efficacement grâce à des outils de traduction automatique, de résumé et de communication.

Changer le rôle de l'écriture

Les outils d'écriture assistée par l'IA (comme les modèles de langage) peuvent aider à rédiger des articles, des propositions de demandes de subventions ou même du code. Les chercheurs peuvent se concentrer davantage sur l'édition, l'utilisation de l'éthique et l'originalité, car l'IA peut générer des contenus standardisés ou non originaux si elle n'est pas contrôlée de près.

Alors qu'aux Etats-Unis les entreprises privées dominent le développement de l’IA de pointe grâce à leurs ressources et à leurs stratégies d’acquisition de talents, le monde académique reste important pour la recherche d’innovations révolutionnaires et la réponse aux défis sociétaux mais à beaucoup plus long terme. Renforcer la collaboration et le financement public pourrait aider à combler le fossé entre ces deux secteurs qui ont besoin de collaborer. Mais dans le domaine du logiciel et des algorithmes, les innovations peuvent arriver très rapidement par d'autres chemins et notamment là où on ne les attend pas. La route vers l'IA Générale, l'IAG, cet IA qui est censé être au moins aussi forte et complète que celle de l'humain, est aujourd'hui une sorte de terrain de chasse gardé par les chercheurs universitaires. Mais pour l'évolution de l'IA, ce n'est pas forcement la seule route que suivront les très nombreux développeurs de l'IA dans les entreprises Big IA jusqu'aux plus petites entreprises IA Natives. Les améliorations et développements qui sont ciblées par le secteur privé de l'IA, incrémentales ou non, seront de plus en plus capables de transformer profondément des domaines spécifiques sans nécessiter une conscience ou une compréhension générale du monde comme le ferait un jour l'IAG. Plutôt que de chercher à reproduire l’intelligence humaine dans toute sa complexité, le développement de l’IA pourrait continuer à s’appuyer sur des outils spécialisés, interopérables et complémentaires, capables ensemble d’accomplir des tâches de plus en plus sophistiquées. Et ce, grâce à un écosystème d’intelligences artificielles spécialisées, travaillant en synergie pour résoudre des problèmes concrets, dans des domaines où l’impact est immédiat, mesurable et bénéfique.

L'apport de l'IA dans l'évolution de la recherche et les interactions entre les recherches académiques et privées permettront d'infléchir mutuellement les démarches de recherche des uns et des autres vers des directions inédites donc pas nécessairement envisagées avant l'utilisation massive de l'IA dans la recherche.

-o-o-

Georges Nahon

Avril 2025

Analyste des tendances technologiques dans la Silicon Valley et aux Etats Unis.

Précédemment, pendant quinze ans directeur général d'orange Silicon Valley à San Francisco.

Sources:

https://bidenwhitehouse.archives.gov/cea/written-materials/2025/01/14/ai-talent-report/

Association for the Advancement of Artificial Intelligence: 2025 Presidential Panel on the Future of AI research

Artificial Intelligence Index Report 2025- Stanford University

AI Talent Report, Regmedia

Le déplacement de la recherche dans l'IA vers le secteur privé aux Etats Unis

Cette nouvelle nous rappelle qu'une grosse partie des cerveaux qui travaillent dans la recherche sur l'IA aux Etats Unis sont passés d'une entreprise à l'autre ou ont créée de nouvelles sociétés d'IA (les IA natives) mais peu de chercheurs universitaires du domaine sont restés dans le cadre de la recherche académique. Les passages d'une société à une autre se sont accélérés depuis l'avènement de l'IA générative en 2022. Cette année-là vingt-six experts en IA ont quitté Google pour créer de nouvelles entreprises.Mais certains ont été réintégrés par Google notamment les deux fondateurs de la startup Character.AI, Noam Shazeer et Daniel De Freitas. De même, l'ancien cofondateur de DeepMind société britannique d'IA acquise par Google, M.Suleyman était devenu PDG et cofondateur d’Inflection AI. Il est maintenant CEO de Microsoft AI.

L'exode en peu de temps d'une dizaine de célébrités d'OpenAi a été la plus marquante : Ilya Sutskever, cofondateur et ancien scientifique en chef d’OpenAI. Andrej Karpathy, cofondateur et chercheur influent dans des domaines tels que la vision par ordinateur et la modélisation générative, Mira Murati, la CTO, directrice de la technologie d’OpenAI, Bob McGrew, directeur de la recherche Barret Zoph, Vice-Président de la recherche et Dario Amodei, Ancien vice-président de la recherche. Il est parti fin 2020 pour cofonder Anthropic, une société de recherche et de sécurité sur l’IA.

Les chercheurs ou diplômés universitaires dans l'IA vont dans le privé

Aux Etats Unis, une part importante de la recherche de pointe sur l’IA est désormais menée par des laboratoires privés, en particulier ceux financés par de grandes entreprises technologiques comme Google (DeepMind), Microsoft, OpenAI, Meta, Apple, Nvidia et Amazon. Ce changement a des implications majeures pour l’avenir de la recherche en IA et ses relations avec le milieu universitaire et le public.Mais le "AI Brain Drain", la fuite des cerveaux académiques de l'IA vers le privé, n'est pas spectaculaire par rapport au besoin très important de talents dans cette discipline dans le privé. Cela ne se traduit pas encore par un grand "Brain Gain", ou gain de talents pour le privé.

Deux ou trois scientifiques renommés de l'ère précédente de l'IA sont effectivement passés du monde universitaire au privé. Quelques-uns comme madame Fei-Fei Li, professeur à Stanford dans l'IA, a fait un passage à Google Cloud pour ensuite revenir à son université. Il y eu quelques noms célèbres comme Demis Hassabis co-fondateur de DeepMind, Ian Goodfellow de Stanford inventeur des GAN, réseaux antagonistes génératifs. Et quelques autres.

En revanche les récents diplômés en IA aux Etats-Unis partent en grand nombre vers le privé et ne poursuivent donc pas de recherche dans le monde universitaire. Des 2021 ce phénomène était signalé et étudié : "Nos résultats [] soutiennent l’idée d’un flux croissant de talents allant du milieu universitaire vers l’industrie, ce qui pourrait nécessiter l’attention des décideurs politiques" ont indiqué les quatre chercheurs auteurs d'un rapport sur le sujet. Selon eux, la raison pour laquelle les décideurs politiques devraient s’inquiéter de tels changements est que les entreprises privées risquent de ne pas donner la priorité nécessaire aux préoccupations éthiques et sociales concernant l'IA.

Une statistique récente du AI Index report 2025 de Stanford montre qu'en 2010 44% des titulaires de doctorats (PhDs) étaient partis dans le privé et que ce nombre serait de 76% en Amérique du Nord en 2024. Cette tendance met en évidence un changement dynamique où l’expertise universitaire est de plus en plus canalisée vers des initiatives du secteur privé.

Pourquoi la recherche dans l’IA se déplace vers les laboratoires privés

Avec les progrès rapides et les objectifs commerciaux de mise rapide sur le marché de produits et services dans des domaines comme l’apprentissage profond, la plupart des meilleurs chercheurs universitaires en IA sont partis dans le privé et ont ici et là maintenu des liens avec le milieu universitaire.De nombreux chercheurs en IA de haut niveau sont passés de l’université à des laboratoires d’entreprise pour obtenir un meilleur salaire, des outils de pointe et la possibilité de travailler sur des projets ambitieux destinés à être confrontés rapidement avec le marché. Des laboratoires comme DeepMind de Google et Anthropic attirent des docteurs du MIT, de Stanford et d’autres universités américaines de premier plan.

Selon le "Artificial Intelligence Index Report 2025 de Stanford", le secteur privé continue de dominer la recherche de pointe sur l’IA. Près de 90 % des modèles d’IA notables en 2024 provenaient de l’industrie, contre 60 % en 2023, tandis que le milieu universitaire reste la principale source de recherches les plus citées du fait d'un focus plus fort que le privé sur les publications. Pour l'IA, les laboratoires privés avancent plus vite que le monde universitaire car ils sont moins encombrés dans leurs activités par les retards dans l’évaluation de leurs travaux par leurs pairs académiques dans l'objectif de publier. Idem pour le financement de leurs travaux par les longs cycles d'obtention de subventions ou de dotations publiques ou privés bien moindres que dans le privé par ailleurs. Dans le privé, les chercheurs peuvent passer de l’idée à la mise en œuvre en quelques semaines ou mois. Et non des années. Pour ce qui est des publications, il existe des différences notables entre la recherche en IA dans les secteurs privé et public. Les chercheurs en IA de l'industrie sont généralement cités deux fois plus que leurs homologues académiques, mais publient moins fréquemment. Mais en parallèle, ces chercheurs semblent atteindre une forme de stagnation académique, ce qui indique que leurs employeurs privilégient davantage la mise en œuvre d'idées éprouvées plutôt que l'exploration de nouvelles approches novatrices. Le rôle de la recherche à long terme plutôt du ressort universitaire trouve bien sa place dans ce contexte.

Un rapport récent de l'AAAI, l'association pour le progrès de l'intelligence artificielle aux Etats Unis, apporte un éclairage précis sur la concurrence privé/académique pour ce qui est de la recherche en AI.

"Le centre de gravité de la recherche en IA se trouve maintenant derrière les portes closes des grandes entreprises technologiques." Les universités ne peuvent pas rivaliser avec elles pour ce qui est des ressources disponibles : données, puissances de calcul et salaires. Les universités américaines ont du mal à retenir les professeurs d’IA et à persuader les diplômés en IA de rester dans le milieu universitaire. L’enjeu est donc maintenant de trouver un rôle pour le monde académique (et la recherche financée par des fonds publics) dans la nouvelle ère de la « big AI », c'est à dire les Big Tech de l'IA (Google/Alphabet, Microsoft, Meta, Amazon, Apple, Nvidia, OpenAI…).

La plupart des répondants à l'enquête menée dans cette étude, (environ 75 %) ont convenu que les universités ont des difficultés à recruter dans le domaine de l’IA et qu'elles ont du mal à s’engager dans des recherches sur l’IA qui demandent beaucoup de ressources (80 %). Il y avait moins d’accord sur la nécessité pour les universités de recentrer leurs priorités de recherche, bien qu’il semble que les répondants estiment que le fait de se concentrer sur l’IA théorique et l’IA multidisciplinaire sont des domaines où les universités pourraient être compétitives.

Les différences entre la recherche académique en IA et celle du privé aux Etats-Unis : le risque de marginalisation de la recherche académique

Il ne s’agit pas seulement de la question de l'accès à des ressources hors de portée des laboratoires universitaires. Il existe des différences significatives d’état d’esprit et de priorités entre le monde universitaire et le monde commercial aux Etats-Unis qui expliquent en partie pourquoi les laboratoires privés sont souvent à l’avant-garde de la mise sur le marché de l’IA générative (et d’autres technologies de la même famille).Dans le milieu universitaire, même si les chercheurs s'intéressent évidemment aux nouvelles technologies numériques, ils mettent souvent plus de temps à envisager leur potentiel commercial et à adapter leurs recherches en conséquence car ce n'est pas leur priorité. lls se concentrent davantage sur la théorie que sur les applications concrètes immédiates de leurs travaux.

Comme disait un ingénieur facétieux, la théorie c'est ce qui n'est pas pratique !

Alors que dans le privé, les entreprises ont des équipes spécialisées de veille et des investisseurs qui recherchent en permanence les prochaines innovations prometteuses. Ainsi, elles repèrent et financent plus vite les recherches et travaux sur des technologies à fort potentiel commercial.

C'est pourquoi quelques chercheurs en IA de haut niveau sont passés de l’université à des laboratoires d’entreprise pour avoir la possibilité de travailler sur des projets ambitieux et proches d'une implémentation réelle pour confronter la réalité et ses exigences. Mais il y a une bonne coopération entre les mondes universitaires et privés pour ce qui est de la famille de l'IA au sens large.

Pourquoi l'IA générative a tant surpris les chercheurs académiques dans l'IA ?

Une démonstration édifiante du décalage entre le privé et l'académique dans l'IA est l'arrivée de l'IA générative. On a pu y voir la différence de perception de l'urgence ou du besoin de traduire les acquis de la recherche en outils même imparfaits mais utilisables par le marché.Pourquoi de nombreux chercheurs académiques ont-ils été pris de court par l’essor soudain de l’IA générative (GenIA) comme ChatGPT, même si les fondations étaient en gestation depuis des années (ou des décennies). Pour être fairplay, même certaines entreprises Big Tech comme Google, Meta et Apple ont également donné l'impression d'être prises par surprise mais quand même beaucoup mieux préparées à répliquer et revenir dans le jeu mené par OpenAI. Avec le soutien financier et opérationnel de Microsoft.

Mais cet incident est indicatif de l'écart qui règne entre les motivations de la recherche académique dans l'IA et celle menée dans le privé.

Quelles sont les raisons de ce décalage ?

D'abord la GenIA a été un saut rapide de la recherche vers un impact réel sur le marché

La recherche académique en IA progresse souvent lentement et prudemment. La GenIA, elle, a fait un bond spectaculaire depuis les laboratoires (d'OpenAI d'abord) jusqu’au grand public. Le succès immédiat de ChatGPT a été inattendu : peu de gens pensaient qu’un tel outil serait aussi utile et adopté si vite. Pas même OpenAI.Le focus des chercheurs était des indicateurs techniques, pas l’expérience utilisateur

Les chercheurs évaluaient les modèles selon des mesures académiques (précision, perplexité, scores BLEU pour les traductions...), mais pas selon leur utilité concrète pour les gens. ChatGPT a réussi pas parce qu'il dépassait les benchmarks académiques, mais parce qu'il était à facile utiliser dans un mode conversationnel compris de tous, rapide, novateur et un peu magique. Et sommes toutes, suffisamment bon (good enough) sans être parfait dans de nombreux domaines pour séduire les masses.

Ce seuil "assez bon" s’est avéré être plus révolutionnaire qu’une précision parfaite.

Effet de surprise devant la "productisation" rapide et le passage ultrarapide à une échelle colossale

OpenAI a entraîné ses modèles (comme GPT-3 et GPT-4) à une échelle gigantesque, bien au-delà des capacités de la plupart des laboratoires académiques. Les chercheurs n’avaient pas accès à autant de puissance de calcul ni à autant de données. En conséquence, et sans suffisamment de recul, ils ne pouvaient pas anticiper l’impact qu’un modèle aussi grand et si bien affiné pourrait avoir sur le grand public qui a rapidement trouvé l'intérêt de ces chatbots que les moteurs de recherche ni Wikipédia ne pouvaient pas concurrencer.

Sous-estimation des comportements émergents des utilisateurs

Beaucoup pensaient que les grands modèles de langage allaient seulement faire de l'auto-complétion de textes de manière un peu plus fluide que ce qui était connu. Ce qui a surpris, c’est l’apparition de compétences inattendues : "raisonnement", traduction, codage/programmation, humour, résolution de problèmes simples.

Ces capacités n’étaient pas explicitement programmées, elles ont émergé spontanément avec le passage à l'échelle — un phénomène mal compris à l’époque.

Une communauté de recherche dans l'IA fragmentée

Le monde de l’IA est vaste. Certains chercheurs se spécialisent dans des domaines comme la vision par ordinateur, la robotique, les neurosciences, l'IA symbolique, l'éthique.

Ceux en dehors du domaine du traitement du langage naturel (NLP) n’ont parfois pas suivi les avancées des transformers et des LLMs inventés par Google et OpenAI essentiellement. Même au sein du NLP, le saut entre GPT-2 et ChatGPT a été un choc.

Pas d'accès pour les gens de l'extérieur aux développements faits dans les entreprises

Une grande partie des travaux les plus avancés (par exemple, GPT-3, ChatGPT, Claude, Gemini) provenaient d’entreprises privées, et non d’universités. Les détails de ces LLMs n’étaient pas toujours publics, de sorte que les chercheurs universitaires étaient souvent en train de rattraper leur retard quand ces LLMs étaient révélés, ou ne savaient pas à quel point la technologie avait avancé jusqu’à ce qu’elle soit ouverte au public.

Mauvaise appréciation des réactions humaines

Les chercheurs académiques ont peut-être aussi sous-estimé la façon dont le publique réagirait à un chatbot qui avait l'air intelligent, utile, facile à utiliser et un peu magique. Le facteur « wow » d'admiration/surprise suscité par le fait de pouvoir "parler" à une machine qui répond comme un humain a été sous-estimé par de nombreux universitaires.

Comment l'IA transforme la recherche académique

Selon plusieurs observateurs, l'IA est en train de redéfinir ce que signifie être un chercheur, tant dans la manière dont la recherche est menée que dans la façon dont les chercheurs définissent leurs rôles. Ce changement se produit de plusieurs façons.Accélération de la découverte

Les outils d'IA peuvent traiter des ensembles de données massifs bien plus rapidement que les humains, découvrant ainsi des modèles, des tendances ou des anomalies qui prendraient des semaines ou des mois à identifier manuellement. Ceci permet aux chercheurs de se concentrer davantage sur l'interprétation des résultats que sur leur recherche.

Passage de la collecte de données à l'interprétation des données

Traditionnellement, les chercheurs passent beaucoup de temps à collecter et organiser des données. L'IA automatise une grande partie de ce processus (par exemple, le web scraping ou récupération de données du web, le nettoyage des données, les simulations d'expériences), permettant aux chercheurs de se concentrer sur l'analyse, la construction de théories et l'application des connaissances acquises.

Redéfinir l'expertise

L'IA permet à des personnes, sans connaissances approfondies dans un domaine, de réaliser rapidement des analyses avancées en utilisant des modèles pré-entrainés ou des interfaces accessibles comme ChatGPT. Cela démocratise la recherche, mais remet aussi en question les notions d'expertise et d'autorité dans un domaine donné.

Améliorer la collaboration

L'IA facilite le travail interdisciplinaire en assurant la traduction entre les différents domaines (par exemple, en aidant un biologiste à comprendre des termes de l'informatique ou inversement). Elle permet également aux équipes mondiales de travailler plus efficacement grâce à des outils de traduction automatique, de résumé et de communication.

Changer le rôle de l'écriture

Les outils d'écriture assistée par l'IA (comme les modèles de langage) peuvent aider à rédiger des articles, des propositions de demandes de subventions ou même du code. Les chercheurs peuvent se concentrer davantage sur l'édition, l'utilisation de l'éthique et l'originalité, car l'IA peut générer des contenus standardisés ou non originaux si elle n'est pas contrôlée de près.

Conclusion

Alors qu'aux Etats-Unis les entreprises privées dominent le développement de l’IA de pointe grâce à leurs ressources et à leurs stratégies d’acquisition de talents, le monde académique reste important pour la recherche d’innovations révolutionnaires et la réponse aux défis sociétaux mais à beaucoup plus long terme. Renforcer la collaboration et le financement public pourrait aider à combler le fossé entre ces deux secteurs qui ont besoin de collaborer. Mais dans le domaine du logiciel et des algorithmes, les innovations peuvent arriver très rapidement par d'autres chemins et notamment là où on ne les attend pas. La route vers l'IA Générale, l'IAG, cet IA qui est censé être au moins aussi forte et complète que celle de l'humain, est aujourd'hui une sorte de terrain de chasse gardé par les chercheurs universitaires. Mais pour l'évolution de l'IA, ce n'est pas forcement la seule route que suivront les très nombreux développeurs de l'IA dans les entreprises Big IA jusqu'aux plus petites entreprises IA Natives. Les améliorations et développements qui sont ciblées par le secteur privé de l'IA, incrémentales ou non, seront de plus en plus capables de transformer profondément des domaines spécifiques sans nécessiter une conscience ou une compréhension générale du monde comme le ferait un jour l'IAG. Plutôt que de chercher à reproduire l’intelligence humaine dans toute sa complexité, le développement de l’IA pourrait continuer à s’appuyer sur des outils spécialisés, interopérables et complémentaires, capables ensemble d’accomplir des tâches de plus en plus sophistiquées. Et ce, grâce à un écosystème d’intelligences artificielles spécialisées, travaillant en synergie pour résoudre des problèmes concrets, dans des domaines où l’impact est immédiat, mesurable et bénéfique.L'apport de l'IA dans l'évolution de la recherche et les interactions entre les recherches académiques et privées permettront d'infléchir mutuellement les démarches de recherche des uns et des autres vers des directions inédites donc pas nécessairement envisagées avant l'utilisation massive de l'IA dans la recherche.

-o-o-

Georges Nahon

Avril 2025

Analyste des tendances technologiques dans la Silicon Valley et aux Etats Unis.

Précédemment, pendant quinze ans directeur général d'orange Silicon Valley à San Francisco.

Sources:

https://bidenwhitehouse.archives.gov/cea/written-materials/2025/01/14/ai-talent-report/

Association for the Advancement of Artificial Intelligence: 2025 Presidential Panel on the Future of AI research

Artificial Intelligence Index Report 2025- Stanford University

AI Talent Report, Regmedia

Autres articles sur le même thème

Quoi de neuf dans la Silicon Valley ?

Software 2.0 : l’IA va-t-elle remplacer les ingénieurs logiciels ?

par Georges Nahon

par Georges Nahon

Mag #23

Lire l'article

Quoi de neuf dans la Silicon Valley ?

L’Intelligence Artificielle Générale (AGI) : La prochaine frontière après les agents et les modèles à raisonnement ?

par Georges Nahon

par Georges Nahon

Mag #22

Lire l'article